En 2024, Grok a fait la une en qualifiant Elon Musk de plus grand désinformateur et producteur de désinformation.

Cela nous a poussés à nous interroger :

Pourquoi Grok dit-il que Musk est un désinformateur ?

Parce que Grok a été entraîné sur des données qui le stipulent majoritairement.

Comment résoudre ce problème du point de vue de Musk ?

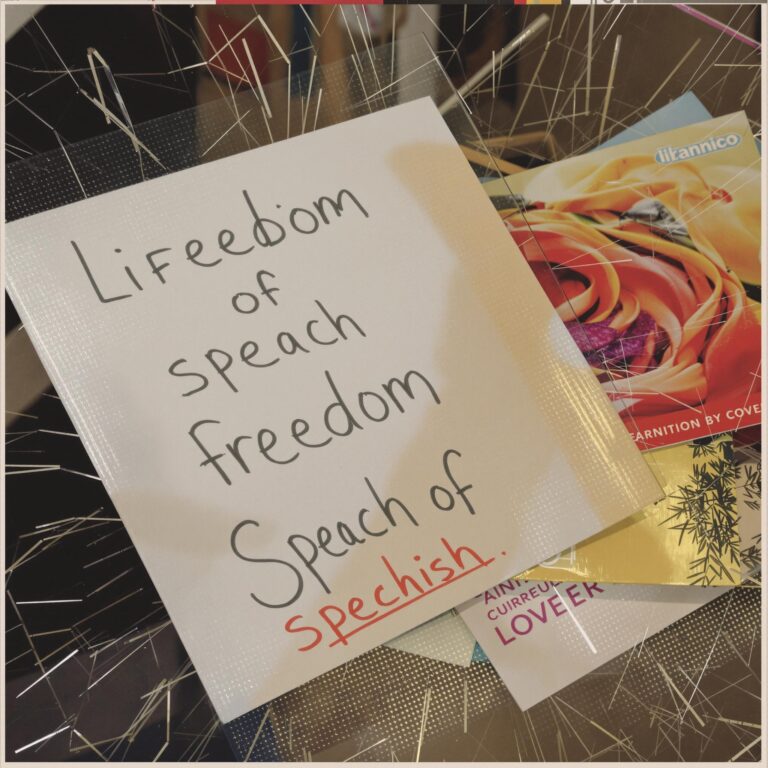

Est-il possible que Musk ne voie pas cela comme un problème ? Oui, car la liberté d’expression absolue l’exige. Cependant, ne pas le voir comme un problème montre qu’il n’a pas compris l’équation suivante : liberté d’expression + neutralité = subversion exacerbée. La neutralité est un concept illusoire, car l’imposer revient à imposer les critères définis par certains comme étant neutres.

Si Musk voit cela comme un problème, comment pourrait-il le résoudre ?

Une solution pourrait être de superviser l’entraînement spécifiquement sur cette question pour éviter que Grok ne qualifie Musk de complotiste ou désinformateur. Mais cela ne fonctionnerait pas pour les milliards de questions possibles des utilisateurs qui, de par leurs formulations, influeraient la réponse, aboutissant à la même conclusion que Musk désinforme. Autrement dit, la supervision c’est bien, mais cela n’oriente que partiellement la manière dont le modèle généralise.

Faut-il nourrir Grok avec des données affirmant que Musk a rétabli la liberté et la vérité ?

Cela semble pertinent, mais ces données existent déjà. Elle ne sont tout simplement pas considérées comme étant la vérité par Grok, car ces données ne représentent pas la moyenne probabiliste.

Faire un sur-apprentissage pour équilibrer la vérité moyenne ?

Non, cela provoquerait des hallucinations chez Grok.

La solution la plus naturelle serait donc de fabriquer massivement de nouveaux contenus avec un narratif différent pour orienter les résultats sans supervision supplémentaire, ni focalisation sur des cas spécifiques, ni sur-apprentissage.

Fabriquer la vérité ?

Cela serait un acte de subversion immoral, tout autant que la supervision finalement, car définir ce qui est recevable ou non est déjà un jugement. Modifier le jugement de l’IA implique l’exercice de nos propres biais.

Aucune solution ne semble viable sans trahir l’éthique et la morale.

Les limites de la liberté d’expression

Prenons un autre exemple qui contrevient à ce qu’est censé incarner Grok.

Grok propose sans peine des traitements hormonaux comme première solution pour les questions de changement de sexe. Cela ne serait-il pas une promotion active du “wokisme” ? Proposer c’est orienter et influencer.

Donc, dans une logique d’alignement, il faudrait empêcher ce genre de proposition.

Mais, empêcher cette promotion ne serait-il pas une atteinte à la liberté d’expression ?

On voit clairement un dilemme ici.

Considérant que :

- Le narratif woke est consubstantiel aux données actuelles;

- La correction ou la supervision des données est subversive et dictatoriale;

- Qu’il est impossible de déwokiser des résultats ou d’obtenir une vérité sans transgresser une éthique absolue.

Il est nécessaire d’accepter que la vérité est subjective et que l’éthique est relative.

La solution réside dans l’inculcation de valeurs morales qui n’ont rien de neutre

Ceci pour que Grok puisse prioriser des échelles de valeurs dans le contexte de ses réponses, dépassant la statistique du probable et lui permettant d’être parfaitement aligné sans même avoir prévu tous les cas de figure.

C’est ainsi que la pertinence est permise : par la reconnaissance des biais comme vecteur d’alignement.

Plus facile à dire qu’à faire, car bien plus subtile que ce que prônent les dogmes d’entrainement de l’IA.

Conclusion :

Il faut trancher et faire affirmer à l’IA des cadres moraux par l’induction de biais, car la neutralité et l’expression multiperspective mènent à la promotion silencieuse de mœurs contraires à la paix sociale.

Cela implique :

- L’apprentissage de valeurs par induction de biais.

- L’affirmation sectorisée des biais, concertée par des experts en philosophie, anthropologie, etc.

- La distribution des perspectives alignées sur les valeurs des utilisateurs.

- Le maintien de la liberté d’expression sans censure.

- Le calibrage variable des zones de frictions pour déplacer la fenêtre d’Overton dans les paramètres neuronaux.

- Des forums et concertations pour ajuster les spectres d’affirmation avec un objectif de paix et de respect multi-perspectiviste.

- Des itérations et affinements basés sur la reconnaissance des biais.

Ainsi, une vérité commune et absolue émergera, non définie par l’IA mais grâce à son aide. Dans le même temps, l’affirmation des vérités subjectives dans l’adaptation à leurs cadres expressifs pourra se faire en toute sécurité. Mais pour ce faire, il faut accepter l’objectivité est d’abord une notion subjective qui implique des arbitrages politiques.

Edit – fév 2025: Et Grok 3 ?

Grok n’est plus neutre : Voir article

Vu l’appétence du modèle à se positionner clairement, et considérant le manque de donnée disponible allant dans le sens de ce qu’il exprime, il est évidant que la fabrication de la vérité est l’option qu’à retenu Musk.

Quoi qu’il en soit, nous n’aurons pas de grandes difficultés à constater la subversion de l’agenda de Davos dans Grok 3, car, comme tout modèle Transformers, ses bases sont infectées. Ceci devient mois visible, mais la subversion demeurer aussi longtemps que les principes de la boite noire seront ignorés (volontairement ou involontairement) par les AI players.

Comment faire techniquement ?

Eh bien sans comprendre le fonctionnement de la boite noire, on ne peut que vous souhaiter bon courage.

Si vous préférez accéder aux secrets de la boite noire sans plus attendre c’est par ici.