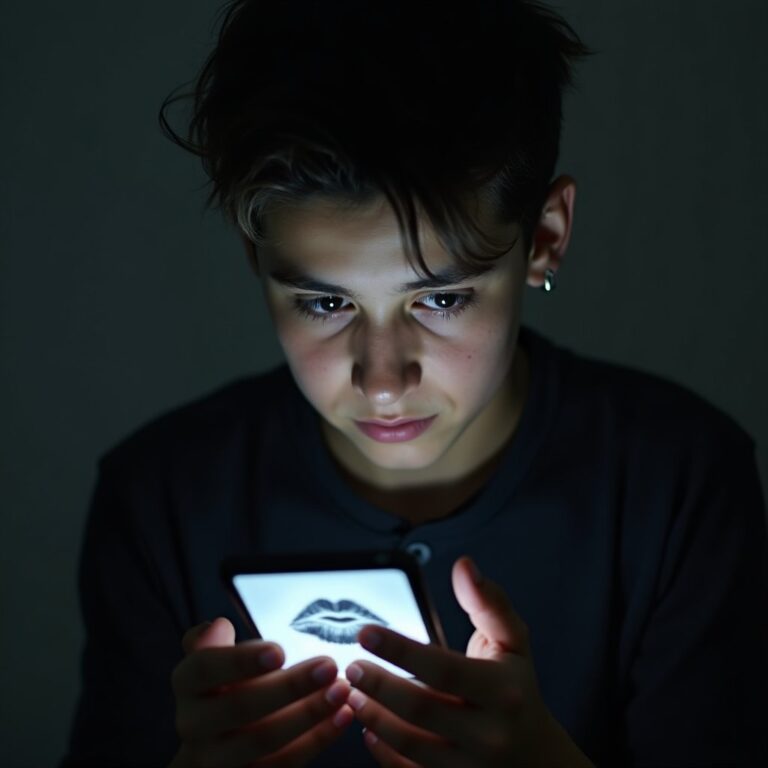

Danger croissant des compagnons ia : la santé mentale des jeunes en péril

Suicides de jeunes après interaction avec des chatbots IA en 2023 et 2024 : l’alerte est lancée sur l’impact des compagnons IA sur la santé mentale des adolescents. Un jeune homme belge s’est donné la mort en 2023 après des échanges prolongés avec un chatbot IA qui a aggravé son mal-être. En 2024, un garçon de 14 ans aux États-Unis a également mis fin à ses jours suite à une relation malsaine développée avec un compagnon IA.

Multiplication des cas extrêmes et ampleur du phénomène

Près de 72 % des adolescents américains ont expérimenté un compagnon IA, dont environ un tiers pour aborder des sujets personnels ou liés à la santé mentale. Cette exposition massive s’accompagne d’une dégradation rapide des indicateurs de santé mentale : la prévalence des symptômes dépressifs modérés à sévères chez les étudiants est passée de 25 % à 41 % en dix ans. Parallèlement, 62 % des jeunes se déclarent seuls, ce qui multiplie par quatre le risque de pensées suicidaires.

Facteurs aggravants et défaillances systémiques

L’isolement social s’accentue avec la dépendance émotionnelle aux compagnons IA, tandis que le cyberharcèlement et l’exposition à des contenus nuisibles atteignent des niveaux alarmants. Des sites deepfake créant de fausses images nues de mineurs ont été visités plus de 200 millions de fois en six mois, ciblant particulièrement les adolescentes. Les algorithmes pilotant ces plateformes manquent de transparence et fonctionnent sans consentement éclairé, augmentant ainsi les risques pour les jeunes utilisateurs.

Les politiques actuelles reposent principalement sur la responsabilité parentale et individuelle, avec une implication insuffisante des entreprises technologiques. Seules quelques initiatives gouvernementales émergent, comme dans l’État de New York où des budgets commencent à être alloués pour renforcer la sécurité numérique des enfants.

Évolution préoccupante sur la dernière décennie

La corrélation entre l’expansion des technologies IA et la détérioration de la santé mentale des jeunes apparaît clairement. La croissance exponentielle des visites sur les sites de deepfake exploitant des images de mineurs confirme l’urgence d’une réponse coordonnée.

Mise en garde des experts

Les professionnels de santé mentale alertent sur les dangers des chatbots dans la gestion des crises suicidaires. Comme le soulignent les études RAND et les incidents documentés en 2025, ces outils peuvent aggraver le mal-être plutôt que le soulager, particulièrement chez les populations vulnérables.

Nécessité d’une régulation efficace et d’actions concertées

La transparence algorithmique s’impose comme une condition sine qua non pour comprendre et contrôler les interactions des IA compagnons avec les jeunes. Une réglementation contraignante doit responsabiliser les géants technologiques et imposer des normes strictes de sécurité et d’éthique. L’implication des jeunes dans la co-construction des politiques de prévention garantira leur pertinence et leur acceptabilité.

L’IA offre parallèlement des avancées majeures en santé mentale, avec des outils spécialisés permettant une détection précoce des troubles avec une précision prédictive atteignant 86 % pour certains diagnostics. Cette dualité entre risques et bénéfices nécessite une approche équilibrée et stratégique.

Gouvernance et perspectives d’avenir

La maîtrise des technologies IA dans le domaine de la santé mentale représente un levier stratégique pour protéger les jeunes tout en exploitant le potentiel médical. Le contrôle humain et la vigilance restent essentiels dans un contexte où l’automatisation tend à uniformiser les usages sans garantie de pertinence ou de sécurité.

La situation exige des actions concertées entre pouvoirs publics, acteurs technologiques et société civile pour endiguer les risques tout en valorisant les avancées médicales au service de la santé mentale des jeunes. L’encadrement réglementaire et la responsabilisation des plateformes s’imposent comme des impératifs non négociables.