Le développement continu et l’extension des tailles de données et de modèles constituent un levier essentiel pour améliorer l’intelligence des modèles d’intelligence artificielle. Cependant, la communauté de recherche et d’industrie fait face à des défis dans la mise à l’échelle de modèles extrêmement grands, qu’ils soient denses ou basés sur des Mixture-of-Experts (MoE). De nombreuses informations cruciales concernant ce processus de mise à l’échelle ont été révélées récemment avec la publication de DeepSeek V3.

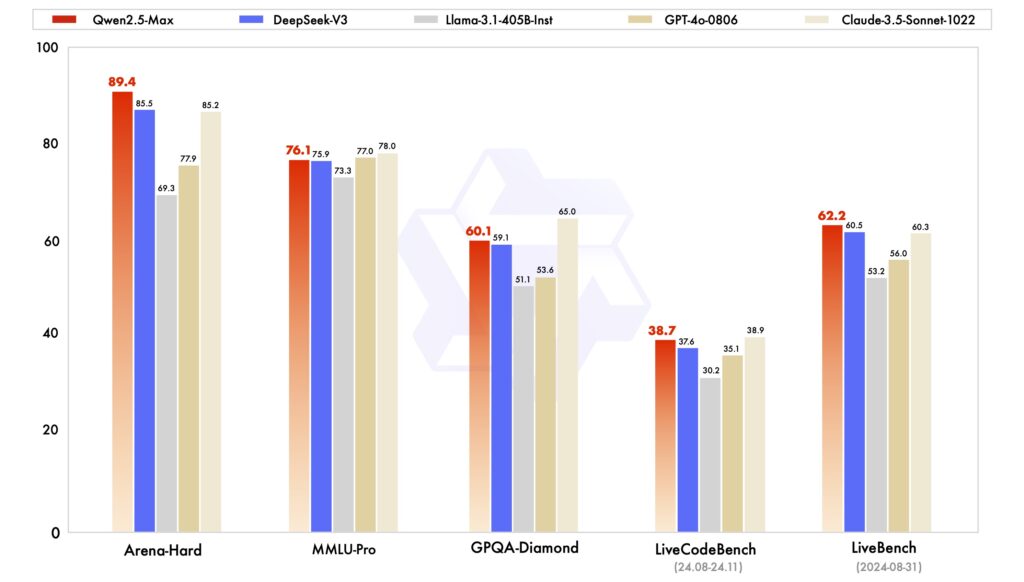

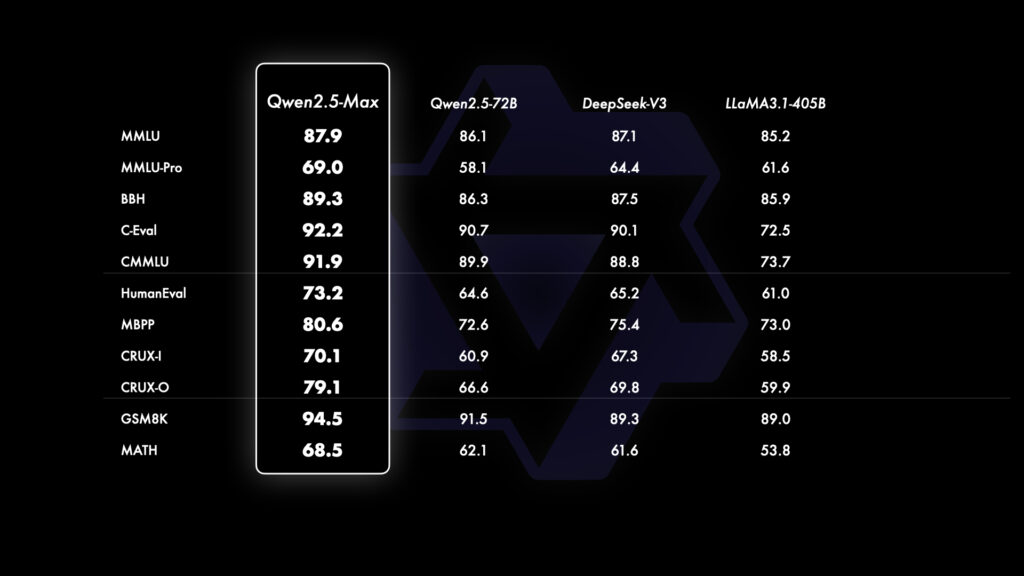

Dans ce contexte, l’équipe de Qwen a annoncé Qwen2.5-Max, un modèle MoE à grande échelle ayant été préentraîné sur plus de 20 billions de tokens. Ce modèle a été ensuite perfectionné grâce à des méthodes de Supervised Fine-Tuning (SFT) et de Reinforcement Learning from Human Feedback (RLHF). Aujourd’hui, les résultats de performance de Qwen2.5-Max sont disponibles.

Accès

L’équipe de Qwen a annoncé la disponibilité de son API via Alibaba Cloud. Les utilisateurs sont également invités à explorer Qwen2.5-Max sur Qwen Chat.